Sokat javít AI-célprocesszorának teljesítményén az Nvidia

Tovább gyorsulnak az Nvidia AI-szuperszámítógépekbe szánt célprocesszorai, melyek ezúttal az elődök egyik legtöbbet bírált hiányosságát, a memória-sávszélességet és a kezelhető memóra mennyiségét bővítik számottevően.

Bejelentette következő generációs AI-gyorsítóchipjeit az Nvidia, mely a piacot az elmúlt években valósággal letarolta a mesterséges intelligencia-megoldások feltanításához és egyéb deep learning feladatokhoz elengedhetetlen célprocesszoraival.

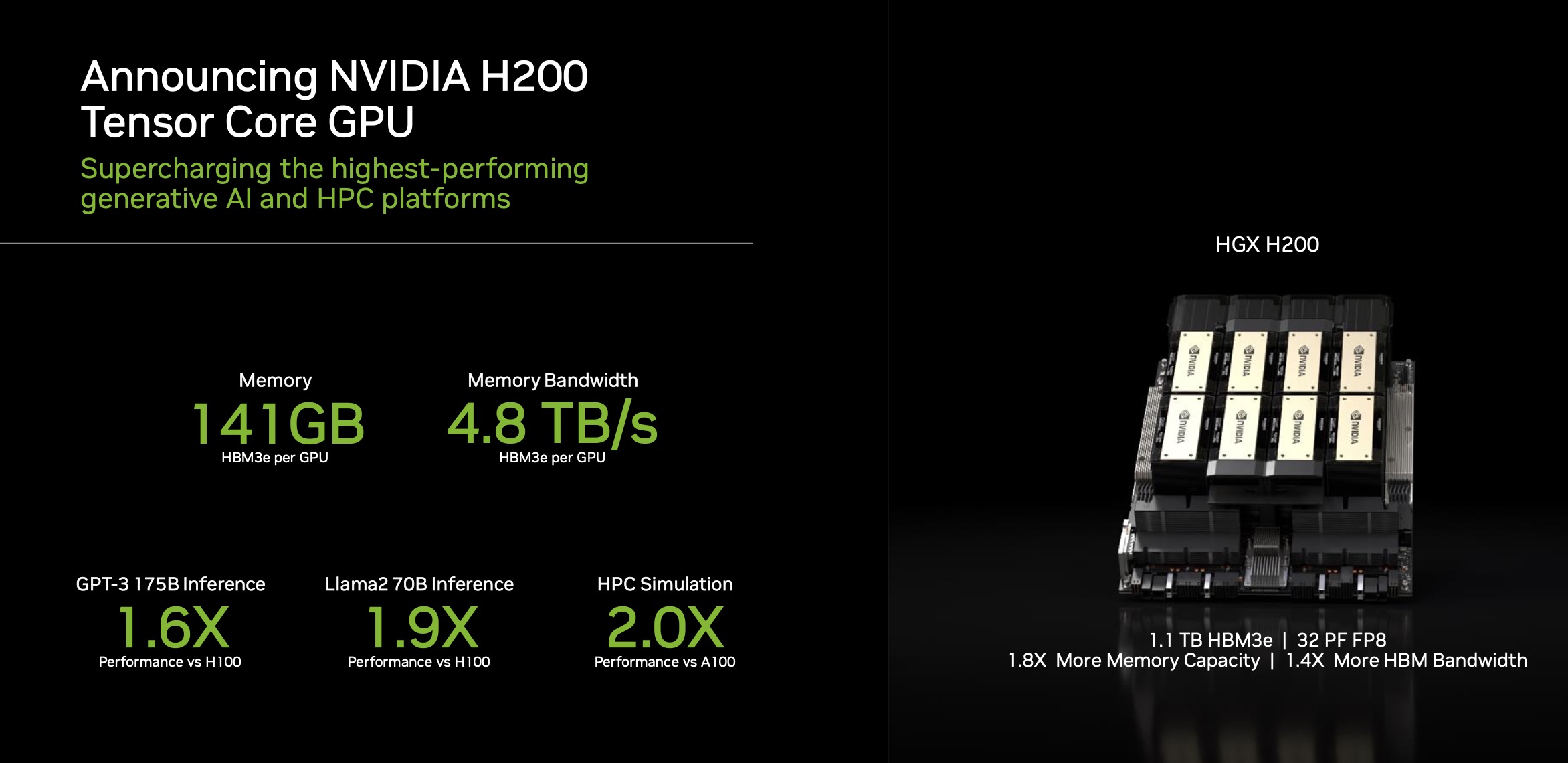

A Hopper architektúrára épülő H200 GPU a manapság rendkívül keresett (olyannyira, hogy a gyártó a mai napig képtelen lépést tartani a kereslettel) H100 közvetlen utódja lesz, a legfontosabb, gyakorlatilag egyetlen különbség pedig a HBM3e memóriák támogatása lehet majd. Ez azonban önmagában óriási teljesítménynövekedést hozhat, tekintve, hogy a korábbi rendszerek teljesítményét kivétel nélkül a memória sávszélessége fogta vissza.

AI: a technológiai robbanás állva hagyta a munkaerőpiacot A technológiai változás sebességét sem a hazai cégek, sem az IT munkaerőpiac nem tudja lekövetni. Az eseményhorizontról azonban már nincs visszafordulás.

Csak az új memóriakezelési-alegységnek köszönhetően a chip memória-sávszélessége 4,8 terabájt/másodpercre nő, ami a H100-hoz képest 1,4-szeres gyorsulásnak felel meg, miközben az egy processzor által maximálisan kezelt memória mennyisége 80-ról 141 GB-ra nő. A korábbi technológiát képviselő, ám szintén széles körben elterjedt A100-as gyorítóhoz a sávszélesség-növekedés még szembetűnőbb, 2,4-szeres.

Az új gyorsítóchipek jövőre, a második negyedévben kerülhetnek piacra, hogy mennyiért, azt egyelőre nem közölte az Nvidia, ugyanakkor a H100-as processzorokat ma volumentől és egyéb kedvezményektől függően darabonként 25 és 40 ezer dollár közötti áron lehet beszerezni - elemzők szerint aligha valószínű, hogy ettől az árszinttől lényegesen eltérne az Nvidia a H200 esetében.

Az Nvidia már augusztusban bejelentette a szintén HBM3e-memóriakezeléssel újító GH200 "szuperchipet", mely a H200 mellett egy ARM-alapú Grace CPU-t is tartalmaz. A kifejezetten szuperszámítógépekbe, tudományos kutatásokhoz szánt platform a H200-zal egy időben kerül majd forgalomba a jövő év derekán.