Valóságos szörnyetegek az Nvidia új adatközponti chipjei

Két igazán figyelemre méltó MI-fókuszú terméket jelentett be tegnap a GTC-konferencián az Nvidia, mely a mesterséges intelligencia megoldások elmúlt néhány évben tapasztalható robbanásszerű fejlődésének egyik legnagyobb technológiai támogatója, egyben haszonélvezője volt.

Tövig nyomja a gázt az Nvidia az MI-fókuszú adatközponti és szuperszámítógépes megoldásainál, melyek rövidesen minden eddiginél nagyobb teljesítményszintet képviselhetnek majd az új, Hopper architektúra és az első rá épülő GPU-nak, a H100-nak, valamint egy vadonatúj, ARM-alapú adatközponti CPU-nak köszönhetően. A vállalat egyben kedden bejelentette, hogy részben az új technológiákra alapozva megépíti a világ legnagyobb teljesítményű MI-szuperszámítógépét, az Eos-t.

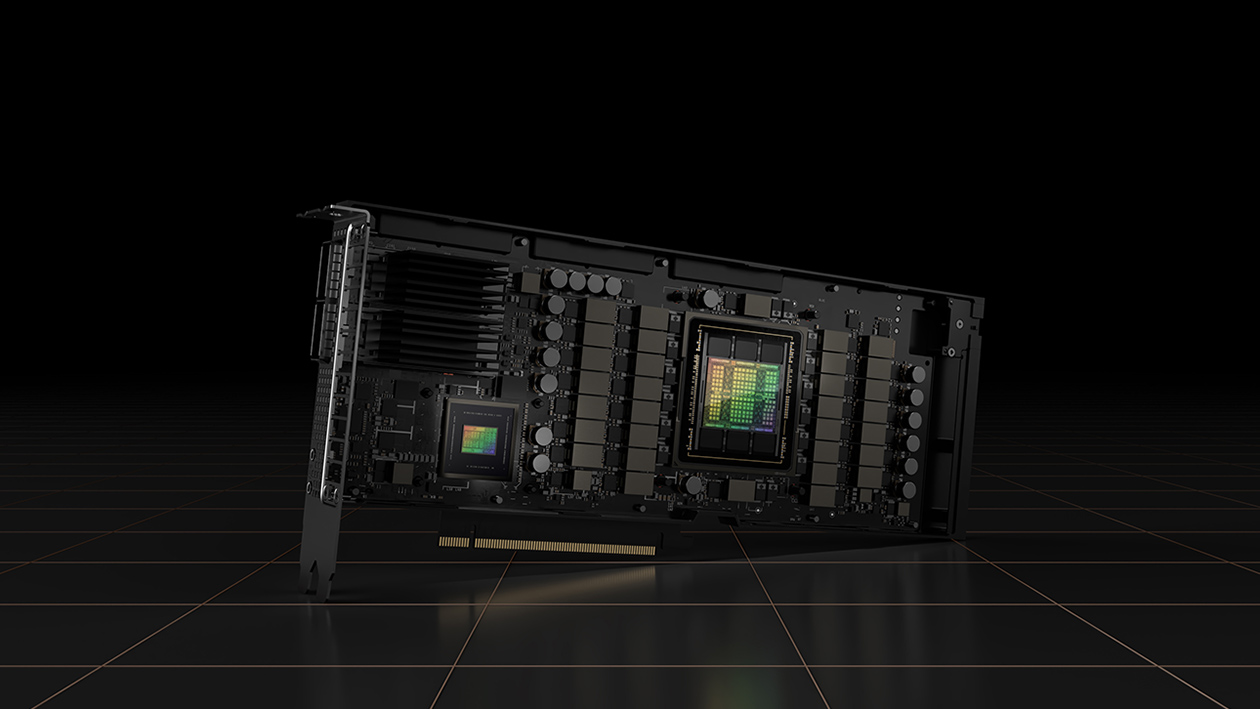

A cég újonnan bejelentett H100-as GPU-i elsősorban a rendkívül népszerű Transformer tanulási modell jelentős gyorsítását hivatottak elérni, így a tanítási folyamat akár a hatszorosára is gyorsulhat, miközben az új generációs Nvidia NVlink révén 256 ilyen GPU is összekapcsolható a korábbinál kilencszer gyorsabb sávszélességet biztosítva.

Egy H100 GPU egyébiránt 80 milliárd tranzisztort tartalmaz, illetve ez a gyártó első olyan gyorsítóprocesszora, mely PCI Gen5 és HBM3 (High Bandwith Memory) támogatást kínál, a rendszer memória sávszélessége ezzel eléri a 3 TB/s-t. Az Nvidia szerint az új chip az előző generációs, A100-as megoldáshoz képest háromszoros teljesítményt nyújt FP16, FP32 és FP64, valamint hatszorosat 8 bites lebegőpontos műveleteknél.

AI: a technológiai robbanás állva hagyta a munkaerőpiacot A technológiai változás sebességét sem a hazai cégek, sem az IT munkaerőpiac nem tudja lekövetni. Az eseményhorizontról azonban már nincs visszafordulás.

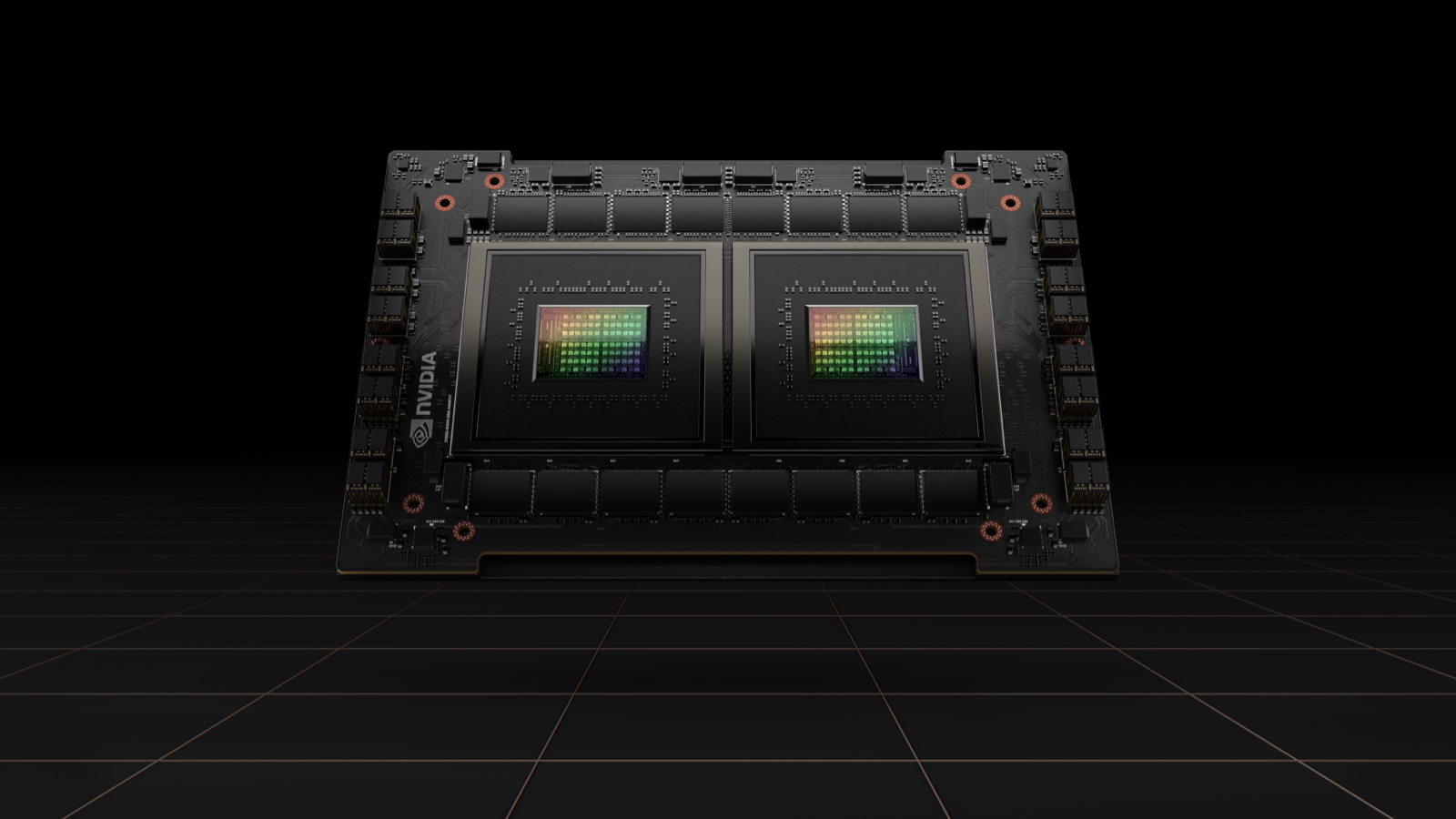

A GTC-n az Nvidia a H100 mellett bejelentette első, ARM-alapú szerverprocesszorát, a Grace CPU Superchip-et, mely valójában két CPU-t kapcsol össze az új NVLink-C2C buszon keresztül. Az újdonság kifejezetten szuperszámítógépes és masszív MI-számításokat végző környezetekhez készül, akár teljes CPU-alapú számításokat végző, akár GPU-gyorsítást használó szerverekhez.

A Grace chipről, illetve a Hopper platformról tavaly áprilisban árult el először részleteket az Nvidia, igaz, a pontos paraméterekkel kapcsolatban akkor még számos kérdés nyitva maradt. A fontosabb specifikációk közül mostanra hivatalossá vált, hogy a Grace 144 ARM magot tartalmaz majd, a chipzilla memória-sávszélessége pedig 1 TB/s lesz.

A processzoros fejlesztéshez kapcsolódóan a vállalat tavaly áprilisban bejelentette, hogy két nagy szuperszámítógép már biztosan épül a Grace-re. Az egyik rendszert a svájci CSCS, a másikat pedig a Los Alamos-i LANL rendelte, összeállításukat pedig HPE alá tartozó Cray végzi majd. CSCS állítja, az Alps névre keresztelt rendszert gépi tanulásos munkafolyamatok mellett tradicionális HPC-s számításoknál is kihasználják majd.

A fenti fejlesztésekről a mostani eseményen nem esett szó, az Nvidia ugyanakkor bejelentette, hogy megkezdte a házon belüli, gigantikus teljesítményű Eos építésének előkészületeit. A Hopper architektúrára épülő, idén üzembe álló rendszer a tervek szerint 4608 H100 GPU-t tartalmaz majd, ami összességében 18,4 exaflops MI számítási teljesítményt biztosít, ezzel négyszer nagyobb teljesítményre lesz képes, mint a világ jelenlegi legyorsabb MI-szuperszámítógépe, a Japánban található Fugaku.