Gépi látásos barkácspakk érkezik Raspberry Pi-hez

Akár a vendégek hangulatát is nyomon követi a megfelelően betanított AIY Vision Kit. A gépi látásra kihegyezett, Raspberry Pi-re támaszkodó fejlesztői csomag még decemberben elérhető lesz.

Új fejlesztői csomag érkezik a Raspberry Pi-hez, amellyel az otthoni barkácsolók különböző gépi látásos feladatokhoz hajthatják igába az apró számítógépet. A pakk a Google AIY programját bővíti, amely a gépi tanulással, mesterséges intelligenciával való ismerkedést könnyíti meg a bütykölni vágyók számára - innen került ki a beszédfelismerési feladatokra szánt Speech Commands Dataset, illetve a Voice Kit is.

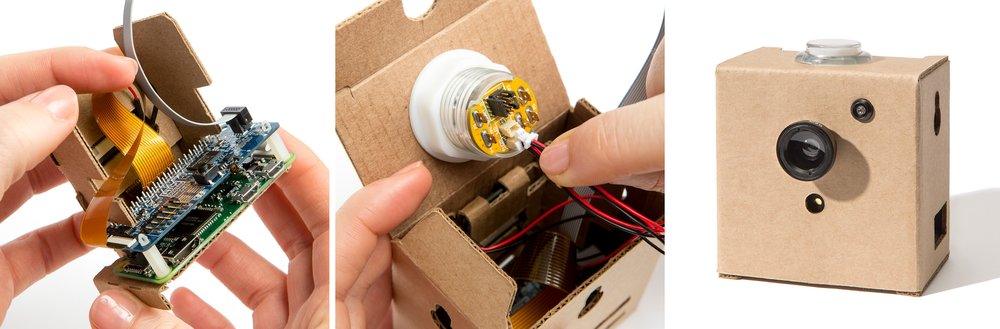

A frissen bejelentett hardverpakk Vision Kit névre hallgat, azzal a vállalat jó szokásához híven kartonpapír házba csomagolja a projekthez szükséges hardvert, noha annak csak egy részét biztosítja a tőle vásárolható csomagban. A barkácsolóknak külön kell beszerezniük ugyanis a Raspberry Pi Zero W lapkát, a Raspberry Pi kameramodult, az adattárolásra használt SD kártyát, illetve a tápellátásról is nekik kell gondoskodni. A csomagban megtalálható viszont a VisionBonnet fejlesztői lapka, egy RGB LED-del megspékelt nyomógomb, egy piezohangszóró, egy széles látószögű, illetve egy makró lencse, egy sor kábel, valamint egy a tripodok felszereléséhez használható foglalat is - no és persze maga a karton készülékház.

AI: a technológiai robbanás állva hagyta a munkaerőpiacot A technológiai változás sebességét sem a hazai cégek, sem az IT munkaerőpiac nem tudja lekövetni. Az eseményhorizontról azonban már nincs visszafordulás.

A pakk legfontosabb eleme nem meglepő módon a VisionBonnet lapka. Utóbbin egy alacsony fogyasztású, Movidius MA2450 VPU (Vision Processing Unit) egységet találunk, amellyel helyben, magán az eszközön futtathatók a különböző képfelismerési és egyéb feladatokhoz szükséges neurális háló modellek. Utóbbiakból a Google mindjárt hármat is biztosít a gyors induláshoz, természetesen TensorFlow alapokon. Az első ilyen a nyílt forrású MobileNets modellekre támaszkodik, azzal mintegy ezer gyakori tárgy ismerhető fel, a második arc- és arckifejezés-felismerésre vethető be, míg a harmadik modell az emberek, macskák és kutyák között tesz különbséget. De lehetőség van a modellek tanítására vagy akár újraképzésére is, ehhez a vállalat egy külön szoftvert is mellékel, amellyel az otthoni munkaállomáson vagy egy kiválasztott felhős környezeten is összeállíthatók modellek a Vision Kithez. Az RGB gomb színei, illetve a hangszóró csipogása és a GPIO tűk egy Python API-n keresztül érhetők el, illetve módosíthatók.

A Google több lehetséges felhasználási módot is felvázol, a különböző növények és állatok felismerésétől kezdve a ház körül ólálkodó kutya nyakon csípésén és a kocsibeálló forgalmának nyomon követésén át egészen a vendégek hangulatának megfigyeléséig és elemzéséig. A vállalat a tervek szerint még december első felében elérhetővé teszi az AIY Vision Kitet több kereskedőpartnerénél, az előrendelések pedig már elrajtoltak.