Interjú Joseph Schutzcal, az Intel processzor kutatási alelnökével

A világ vezető processzorgyártójaként az Intelen belül külön részleg foglalkozik a jövőbeni technológiák kifejlesztésével, melyekkel biztosítható a processzorok további töretlen fejlődése. Joseph D. Schutzcal beszélgettünk, az Intel processzor-technológiai laborjának igazgatójával.

Joseph D. Schutz az Intel processzor-technológiai laborjának igazgatója, a vállalat egyik alelnöke. Feladata olyan jelenlegi és jövőbeni problémák, kihívások kutatása és megoldása, melyekkel biztosítható a processzorok magas ütemű fejlődése. Immár több mint 25 éve áll a vállalat alkalmazásában, többek között résztvett az eredeti 386-os, egy 486-os, a Pentium és Pentium II családok egyes tagjainak fejlesztési munkálataiban, de köze volt a Prescotthoz és a Cedar Millhez is. Végzettsége villamosmérnök, hét szabadalmat jegyez.

HWSW: Mi a legnagyobb kihívás a chiptervezésben?

Joseph D. Schutz: Először is borzasztó sok tranzisztor van egy chipen, a csapatok elég nagyok, és sok különböző képességre van szükség. Van egy csapat, ahol kilencszáz emberünk dolgozik egy chipen. Az Intel számára egy chip egy darab szilícium, de egyúttal sok fejlesztés és befektetés is. Őszintén szólva a koordináció, hogy minden kész legyen, az egyik legnagyobb kihívás, vagyis ez a munkaszervezői szerep egy rémálom. Ha az integrált áramkörök iparágára tekintünk általánosságban, számos vállalat, köztünk a miénkkel, időnként nem tudja tartani az ütemtervet. Azt gondolom tehát, ez az egyik legnagyobb probléma.

Az ember talán azt gondolná, hogy a szilícium megmunkálása nagyobb kihívás, de az Intelnél ez valóban nem probléma. Egy olyan nem szilíciumos [félvezetőgyártással foglalkozó – a szerk.] tagnak, mint én, ez egészen bámulatos, hogy képesek vagyunk erre, bevezetni és felfuttatni a gyártást időben.

Ha kevésbé a menedzsment, hanem inkább a technikai oldalát nézzük, akkor a sávszélesség a DRAM és a [processzor] chip között, de a sávszélesség általában is egy nagy probléma. Most ez nagyjából rendben van, de ha tíz évre kitekintünk, gondban kezdünk lenni, hogy hogyan csináljuk. Ma az a vélemény, hogy egyszerűen csak minél több és több memóriát kell rakni a chipekre -- de nem teheted rá az összeset, a vezetékek és a fogyasztás miatt. És ott vannak a párhuzamos alkalmazásokhoz való szoftverek, ez is kihívás. Szóval azt gondolom, a sávszélesség és a szoftver jelentik a legnagyobb kihívást.

HWSW: Korábban az x86 processzorok, az órajelek növelése és az architekturális fejlesztéseik révén úgy növelték szakadatlanul a teljesítményt, hogy a szoftvereket nem volt szükséges újraírni vagy újrafordítani. A többmagos chipek megjelenésével ez megváltozott.

Joseph D. Schutz: Pontosan így van. Néha olyan választás elé kerülünk, hogy kizárólag az új dolgokat gyorsítsuk fel, vagy a régieket is? Mindig igyekszünk a régieket is. Ha van tehát egy szoftvered, akkor hogyan kell még többet kihozni belőle anélkül, hogy újra kellene írni, mert az is drága. Ez egy akadály a fejlesztés előtt: ha valakinek van egy szoftvere, és az új processzorához új szoftverre is szüksége lenne, akkor nem vásárolná meg a termékünket.

HWSW: De most új szoftverekre van szükség...

Joseph D. Schutz: Két dolog történik egyszerre. Az egyik, hogy egyre több és több párhuzamosság van, a másik pedig, hogy ettől függetlenül is egyre növekszik a szoftverek komplexitása, az egyszálú programok is bonyolódnak, a kódsorok növekednek. Azt gondolom, hogy a programozóknak a párhuzamosságtól való függetlenséghez egy magasabb absztrakciós szinten kell dolgozniuk. A teljesítmény drasztikus növeléséhez párhuzamos hardverre van szükség. Azt gondolom, mindkét esetben magasabb absztrakciós szinten kell programozni. Van egy kutatónk például, aki párhuzamos primitívekkel dolgozik. Ekkor például azt mondjuk a gépnek, hogy szorozzon össze két vektort. Ennyi az összes kód. Ez sok-sok kóddá fordítódik át, melyet sosem látunk. És ennek úgy kell történnie, hogy a programozónak ne kelljen azzal törődnie, egymagos, vagy 16 magos képen futtatja-e. Ez a fajta absztrakt gondolkodásmód szükséges lesz ahhoz, hogy a programozók kezelni tudják az átmenetet. Mert egy átmenetben vagyunk, ahol az embereknek egyre több és több magja lesz [a számítógépében]. A laptopok 45 százaléka kétmagos már most.

HWSW: Ha jól értem tehát, akkor a szoftverfejlesztést függetleníteni kellene valahogy a hardvertől?

Joseph D. Schutz: Igen. Az emberek tipikusan azt gondolják a hardverfüggetlenségről, hogy le kell mondaniuk a teljesítményről, de vannak olyan nyelvi absztrakciós eszközök, melyek számos hardvert támogatnak csekély teljesítményveszteséggel. Mikor most szoftver absztrakcióról, akkor az absztrakció egy új szintjéről beszélünk. Például, ha 100x100-as mátrixokkal dolgozunk, és definiáltuk azokat, akkor csak csak annyit kell mondani a gépnek, hogy szorozza össze A-t B-t és C-t, és a többiről a nyelvi fordítók gondoskodnak, melyek biztosítják a megfelelő teljesítmény anélkül, hogy foglalkozni kellene a hardver működésével.

HWSW: Már öt évvel korábban beszélt az Intel spekulatív többszálúsításról, de még mindig nem érkezett meg. Mi a helyzet?

Joseph D. Schutz: Ebben a típusú többszálúságban azt gondolom, sokat haladtunk előre. Több ember is dolgozik rajta most, mint akkor. Ez egy igen nehéz probléma, mert a szoftverben megpróbálsz olyan kódrészleteket találni, melyek nem függnek egymástól, és párhuzamosan futtatni több magon. Biztosítani kell, hogy az összes függőség lekezelésre kerüljön, és biztosnak kell lenned, hogy ez az újonnan létrehozott szál írhat-e a memóriába. A barcelonai kutatóközpontban van működő példány négy szállal, mely számos tekintetben megvalósítja ezt.

HWSW: Ez különbözik a Sun Microsytems Rock szerverprocesszorában megjelenő felderítő vagy árnyék szálaktól?

Joseph D. Schutz: Igen, de azt is mi publikáltuk elsőként.

HWSW: Ha jól értem tehát, akkor a spekulatív többszálúsítás a meglévő szoftvereket is gyorsítja?

Joseph D. Schutz: Igen, így van, ez a cél. Az emberek keményen dolgoznak rajta. Ez egy kutatási projekt, nem baj, ha rosszul sül el, vagy tévedsz. Ha egy hiba termékbe kerül, az borzasztó. Ha felfedezel valami fantasztikusat, az jó, de ha a felfedezés elég ostobaság, az is rendben van, mert megakadályozza, hogy a vállalat elkövesse még egyszer. Jelenleg a spekulatív többszálúság még mindig jónak tűnik.

[oldal:Energiahatékonyság és memóriafal]

HWSW: A Prescott koncepcionális tervezése olyan 1999 magasságában indulhatott, és extrém, 4 gigahertz feletti frekvenciákat célzott meg. Ehhez képest 2004-ben igen gyorsan a többmagos felépítés felé váltott az Intel? Mi történt, mit nem láttak előre?

Joseph D. Schutz: Az egyik dolog, amit érdemes tudni, hogy az Intel tele van nagyon okos, függetlenül gondolkodó emberrel, akik nem mindig ugyanazt gondolják. Többféle nézőpontunk van, és az egyik dominánssá válik. Végül rájöttünk, hogy a frekvencia mindenáron való fokozása nem hatékony. És volt ez a másik, a Pentium M irányunk, mely a vártnál sokkal jobbnak bizonyult, hasonló vagy jobb teljesítményt nyújtott jobb fogyasztás mellett. A fogyasztás nagyobb probléma, mint a teljesítmény.

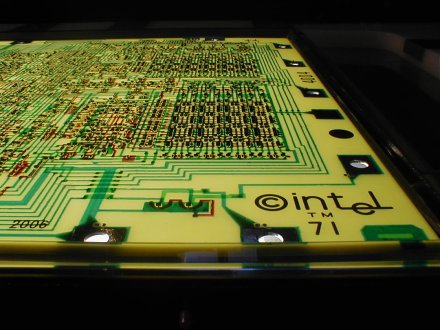

| Prescott |

|

A Prescott projektből többet tanult az Intel, mint bármi másból valaha. Az egyik dolog, hogy hogyan kezeljük a fogyasztást. Időnk nem volt, hogy minden megoldást implementáljunk, de így tudtuk felére csökkenteni a fogyasztást [később]. Az érdekesség tehát, hogy a Prescott egyrészt rosszul néz ki, tudjuk, hiszen mi csináltuk, őszintén szólva jobban is megcsinálhattuk volna, de nagyjából 1 éven belül felére szorítottuk le az energiát. Olyan dolgokat is tanultunk, amelyeket a többiek, akik Core architektúrán dolgoztak, előnyükre tudtak fordítani.

HWSW: Térjünk rá erre a 80-magos szörnyetegre....

Joseph D. Schutz: Ó, ne hívjuk szörnyetegnek. Valójában nem is használ sok energiát, kevés utasítást hajt végre [egy-egy mag]. Ez egyébként egy matematikai probléma. Ha megnézzük a modern magok méretét és teljesítményét, a frekvencia alapján meg lehet ítélni, mire képes. Érezni lehet ugye, hogy ha csökkentjük a mag méretét, lelassul – de a fogyasztás sokkal gyorsabban csökken a teljesítménynél. Ez egy érdekes kompromisszum Egy sokkal alacsonyabb fogyasztású magot sokkal kisebb méretűre is lehet alkotni. Ezen az úton haladva mi a kutatáson azt tehetünk, amit csak akarunk. Ha terméket kell csinálni, akkor meghatározott időkerettel és ésszerűen párhuzamosított kóddal is törődni kellene.

HWSW: A processzorok komplexitásának évtizedeken tartó fokozódását követően kisebbek és egyszerűbbek lesznek a magok?

Joseph D. Schutz: Az energiahatékonyság optimalizálása csak egy töredéke a szempontoknak. A cégen belül nincs egységes egyetértés. Ez teljesen rendben van az Intelnél, lehet vitatkozni. Az én munkám az, hogy a teljesítmény előtt álló akadályokat keressem, többszálú, masszívan párhuzamos hardverrel -- ez a munkám! Nem végezném jól, ha nem próbálnék meg érvelni a kisebb magok mellett. A termékekért felelős vezetők feladata, hogy biztosak legyenek benne, hogy el lehet adni a vevőknek, a vevő megveszi, és értéket jelent számára. Én korlátokat keresek, technikai korlátokat, ő a piaci realitást – nekünk nincs meg ez a felelősségünk. Ha nekem kellene ezzel foglalkoznom, akkor azt mondanám, igen, legyenek kisebbek, legyen több belőle, de csak olyan ütemben, ahogy az ügyfelek el tudják fogadni, például a futtatott alkalmazások fényében.

HWSW: A tranzisztorszám exponenciális növekedésével és a gyártástechnológia által kialakított struktúrák zsugorodásával mekkora problémát jelent a megbízhatóság garantálása?

Joseph D. Schutz: Törődnünk kell az elektromigrációval, vagy például az önmelegedéssel, mikor egy magas aktivitású tranzisztorblokk forró, és alatta meghúzódó vezetéket is felforrósítja, amely így kevesebb elektromosságot szállít, így figyelembe kell venni a vezeték körüli áramkört. Forró pontokat keresünk, részekre osztjuk a chipet és kalkuláljuk a hőmérsékletet. Aztán megnézzük az egyes nagyobb szeletek működésének megbízhatóságát, és bithibákat keresünk. Egyre több struktúrán van paritásvédelem, hibajavítás – ezek azok a dolgok, amelyekkel foglalkozunk. Minden egyes újabb gyártástechnológia újabb megoldandó feladatokat ad ebből a szempontból.

Egy csapat nemrég fejezett be egy projektet, nem hiszem, hogy túlságosan szenvedtek volna ezektől a gondoktól. Történelmi léptékkel nézve ugyanakkor sokkal többet foglalkozunk vele, mint tíz évvel ezelőtt, és kitekintve ez a jövőben továbbra is gondot fog jelentei, hosszabb távon előrejelezhetetlen. Mondok két példát. Az egyik, hogy a SRAM 6T cellái méretben rosszul skálázódnak, és ez korlátozza a feszültség csökkentését, erre egyelőre nincs is megoldás. A másik, hogy a tranzisztorok idővel öregednek, vagyis lassulnak, így különböző áramkör topológiákat vizsgálunk meg, hogy kezeljük ezt a jelenséget.

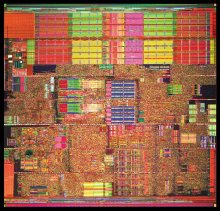

| 3D-ben szervezett flash chipek |

|

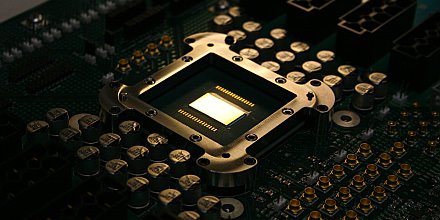

HWSW: Az Intel mérnökei tavaly decemberben publikálták, hogy elkészítették a Prescott háromdimenziós változatát, bemutatva annak előnyeit az energiahatékonyság terén, és válaszként a tranzisztorblokkokat összekötő vezetékek romló késleltetésének problematikájára. Láthatunk a jövőben ilyen chipeket a piacon? Mikor válik ez szükségessé?

Joseph D. Schutz: Az Intelen belül két meghatározó nézőpont van jelenleg a háromdimenziós felépítéssel kapcsolatban. Az egyik klikk a logikát szervezné három dimenzióba, felosztaná a logika egyes részeit. A másik frakció a gyorsítótárak és a memória topológia számára vizsgálja a 3D-t. Ez utóbbinak sikerült felülkerekednie, és az emberek azt gondolják, az az ígéretesebb, és a nehezebb problémát oldja meg.

HWSW: A memória problémát...

Joseph D. Schutz: Igen, a memória problémáját. Ha mi, a kutatásnál a könnyűekkel foglalkozunk, és nem oldjuk meg a nehéz problémákat, akkor talán a versenytárs teszi meg – és a versenytársunk erős. Jelenleg úgy gondoljuk tehát, hogy a sávszélesség, a memória problémája az, amelyekkel foglalkozni kell a háromdimenziós chipeknél, a gyártással, összeköttetésekkel.