Túl erős gépet igényelt volna az eredeti Longhorn

[Microsoft Watch/HWSW] Ellentétben a korábbi hírekkel most már biztosnak látszik, hogy a Longhorn központi rendszermoduljai nem a .NET keretrendszer 2-es változatára fognak épülni. Ez a készülő operációs rendszer teljesítménye szempontjából pozitív változás, azonban meglehetősen váratlanul érte az operációs rendszer fejlődését nyomon követő fejlesztőket.

Jelentős változások a Longhorn architektúrájában

A .NET keretrendszer második nagyobb kiadása még ez év végén, a Visual Studio 2005 és az SQL Server 2005 megjelenésével egy időben várható, illetve a keretrendszer megtalálható lesz a Longhorn részeként is, hiszen az operációs rendszer képességeinek egy kisebb hányada változatlanul erre a technológiára fog épülni. A Windows API Platform (WAP), ami első sorban az Avalon prezentációs alrendszert és az Indigo kommunikációs alrendszert tartalmazza, szinte teljes egészében a .NET keretrendszer 2.0-ás verziójára épül és a WinFX osztálykönyvtár részeként lesz elérhető.

A változás egyben azt is eredményezheti, hogy a Longhorn más újdonságainak programozásához nem lesz feltétlenül szükség az új keretrendszerre, hanem a korábbi Win32 API-hoz hasonló interfészeket kell majd elérni, csakúgy, mint a jelenlegi Windows XP és Windows Server 2003 operációs rendszerek esetében. A redmondi óriás várhatóan nem fog sokat beszélni a változásról, elvégre konkrétan sosem ígérték, hogy az operációs rendszer teljes egészében a .NET keretrendszer 2-es változatára épülne, mégis, az esettel kapcsolatban megkérdezett fejlesztők szinte mind meglepődésüknek adtak hangot.

"A Longhorn eredeti tervei szerint a komponensek legnagyobb részét a .NET keretrendszer következő változatára építették volna. Azonban a .NET keretrendszer 2.0 késedelmei miatt Bill Gates nem tartotta jó ötletnek, hogy a Longhorn legfontosabb építőkövei .NET-alapúak legyenek" -- tudatta egy neve elhallgatását kérő fejlesztő.

A hardverek fejlődésének lassulása jelenti a legnagyobb problémát

"A Longhornban eredetileg szinte mindent C#-ban fejlesztettek volna a keretrendszer segítségével, azonban a keretrendszer olyan hardverelemek meglétét követelte volna meg, amelyek a következő öt évben, vagy még ennél is később fognak csak elterjedni. Ezért a Microsoft mindent újraír a Longhornban" -- ismertette egy újabb fejlesztő, aki szintén nem kívánta felfedni kilétét. A fejlesztő hozzátette, hogy a Windows csapat a keretrendszerrel kapcsolatos változtatásokat múlt nyáron, a "Longhorn Reset" kapcsán találta ki. Mindezek alapján már érthető, hogy a Longhorn jelenlegi, WinHEC-en kiadott előzetes változata miért nem tud lényegesen többet, mint egy évvel ezelőtt -- bár az kétségtelen, hogy sebessége sokat javult.

A "Longhorn Reset" a Microsoft azon bejelentését takarja, amikor ismertették, hogy a WinFS -- a Microsoft újszerű adattára és fájlrendszere -- és még jópár eredetileg tervezett képesség nem lesz megtalálható az operációs rendszerben. Az elsődleges cél az lett, hogy a Longhorn még 2006 közepén-végén megjelenhessen a nagyközönség előtt. Mivel a WinFS is nagyrészt a .NET keretrendszerre épül majd, ezért érthető, hogy a vállalat miért döntött mellőzése mellett. Azáltal, hogy a WinFS nem lesz része az operációs rendszernek, a rendszerkomponensek legnagyobb része nem kell, hogy a keretrendszert, vagy arra épülő modulokat használjon, ami jelentősen növeli majd a rendszer teljesítményét.

A sorozatos kavarodások azt jelzik, hogy a hardver és a szoftverfejlesztés szinkronban fejlődése felborult. Mint ahogy a 64 bites processzorok kezdeti elterjedését a Windows x64 kiadásainak közel egy éves késése akadályozta, addig a Longhorn legérdekesebb képességeinek kihagyása többnyire annak a számlájára írható, hogy a hardverelemek közel sem fejlődnek olyan sebességgel, mint ahogy az pár évvel ezelőtt sejthető volt, amikor a Longhorn tervezése megkezdődött.

Ha például a processzorok fejlődése nem ütközött volna a jelenleg tapasztalható problémákba, az órajel növelése valamint a miniatürizáció folytatása lehetséges lett volna, akkor nagy eséllyel nem kellett volna a Microsoftnak sem úgy döntenie, hogy átalakítja a Longhornnal kapcsolatos terveit.

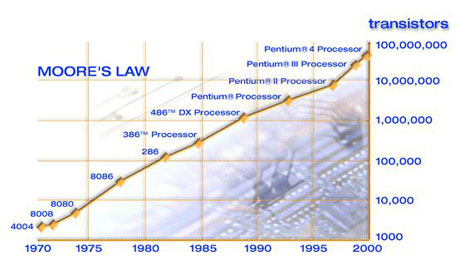

Még mindig érvényben van Moore törvénye?

Sajnos egyre inkább úgy tűnik, hogy sem a 64 bit, sem a kétmagos architektúra nem teszi lehetővé a három-öt évvel ezelőtti villámgyors teljesítmény-növekedési ütem folytatását. Bár mindkét technológia jelentős eredményeket tudhat magáénak, mégis ahhoz, hogy a számítási teljesítményt tovább lehessen növelni az elvárt sebességgel, ahhoz még lehet, hogy néhány évet várni kell.

Moore törvénye a gyakorlatban úgy tűnik, egyre kevésbé alkamazható arra, hogy a rendszerek jövőbeli teljesítményét megjósolja. Habár az Intel (marketing-) tevékenységét teljesen áthatja a Moore-törvény, egyértelmű, hogy az sem eredeti, sem módosított formájában nem igaz már -- sőt, egyes vélemények szerint soha nem is volt az.

Moore törvénye mindazonáltal hozzávetőleg jó iránymutató volt az informatikai teljesítményét tekintve. Az eltelt évek során Moore törvényét sokféleképpen (félre-)értelmezték, a számítógépek sebessége, vagy akár az adattárolási kapacitásuk kapcsán is felmerült a törvény érvényessége. Most is mindössze a "törvény" legfontosabb paramétere változott meg: már csak három évente duplázódik a chipekre integrálható alkatrészek -- ellenállások, tranzisztorok -- száma a korábban megállapított kettővel szemben, és ez még mindig nem sokat árul el az új számítógépek és alkatrészek tényleges sebességéről.

Az igazsághoz az is hozzá tartozik, hogy a sebesség növelése ezentúl már nem csak a hardverek fejlődésén fog múlni. Míg korábban egy gyorsabb processzor minden korábbi alkalmazás teljesítményén javított, addig például a többmagos processzor-architektúrák igazán akkor jelentenek javulást, ha az alkalmazások többségét újraírják, áttervezik. Ezáltal a sebesség növelése a hardver és szoftvergyártók közös feladatává válik, ahol mindkét félnek figyelembe kell vennie a másik technikai problémáit, és konkrét megoldásait. A hardverek fejlődése ezentúl már nem csak a számítási teljesítmény növekedését jelenti a szoftverfejlesztők számára, hanem egyben újfajta fejlesztési módszerekre is kényszeríti őket.

Az új technológiák homokozója: a konzolok

Az új generációs konzolok -- az Xbox 360 és a Playstation 3 --- megjelenése lesz várhatóan az első komolyabb lépés arra, hogy az új ötletekre épülő hardverek képességeit megfelelően kihasználják a szoftverfejlesztők. A konzolok esetében nagy szerencse, hogy a korábban kiadott játékok sebességének növekedését senki nem várja el az új hardverek megjelenésekor, azonban a kompatibilitás mindig is kulcskérdés marad. Ennek köszönhetően a gyakorlatban itt próbálhatóak ki a legegyszerűbben az új technológiák, és itt fognak kialakulni a többmagos fejlesztéshez szükséges leghatékonyabb fogások.

A konzoloknál alkalmazott újszerű megoldások remélhetőleg hamarosan a PC-ken is elérhetőek lesznek. Az IBM már meg is tette az első lépést ezen az úton, mikor bejelentette, hogy a Cell architektúrát és a rá épülő technológiákat más vállalatok és fejlesztők rendelkezésére bocsátja. Kérdéses, hogy a Microsoftnak mik a szándékai a PowerPC architektúrával, hiszen legfrissebb operációs rendszerei nem támogatják azt.