A negyedik GeForce

Már jó ideje tudni lehetett, hogy az NVIDIA a cég filozófiájává tett hat hónap, új termék mantrához hűségesen idén tavasszal jelenti be következő generációs grafikus chipjét. Ma jött el a nagy nap, mely egy teljes termékarzenált hozott GeForce4 néven...

Minthogy a ma hivatalosan is útjára indított GeForce4 termékcsaláddal kapcsolatban számos információ szivárgott ki az utóbbi hónapok alatt, komolyabb meglepetést nem okozott az esemény. Ám az immár biztosnak mondható információk birtokában mégis ésszerűnek látszik áttekinteni, hogy mit is takar a GeForce4 elnevezés. Amint ez majd később kiderül, mindez nem teljesen magától értetődő.

Elsőként talán érdemes leszögezni, hogy a GeForce4 messze nem tekinthető olyan jelentős technológiai előrelépésnek a korábbi generációs chipekhez képest, mint amilyen a GeForce3 volt a GeForce2-höz képest. Amint azt az NVIDIA oldalán néhány napja feltűnt farkasemberes teaser is sugallta, a GeForce4 alapvetően nyers, vad erejében és nem a támogatott feature-ök számában múlja felül elődjét. Ez ugyan nem jelenti azt, hogy a GeForce4 nem is tartalmaz semmiféle újdonságot elődjéhez képest, de ezek többnyire a cég régi adósságainak törlesztésére korlátozódnak.

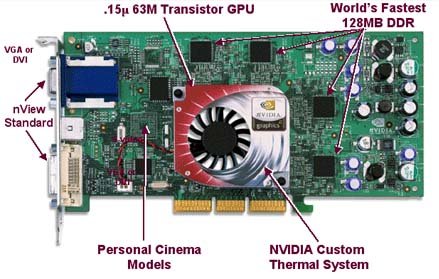

A legerősebb GeForce4, a Ti4600

Két jól elhatárolható chipcsaládra tagolhatóak az újonnan bejelentett termékek. A teljesítményre éhes hardcore gamerek számára készült a három GeForce4 Ti, melyek teljesítményük szerint a GeForce4 Ti4600, GeForce4 Ti4400 és GeForce4 Ti4200 elnevezéseket kapták. E chipek architektúrájukban nem, csupán működési sebességükben térnek el egymástól.

Amint az a képről is leolvasható, a GeForce4 Ti (ahogy a GeForce4 termékcsalád egésze) továbbra is 0,15 mikronos gyártástechnológiával készül. Az órajel növelését az tette lehetővé, hogy az NVIDIA saját megoldást dolgozott ki a grafikus processzor hűtésére, mely a chipek tartozékának tekinthető, s mely a cég bevallása szerint a jelenlegi megoldásoknál sokkal hatékonyabban képes hidegre tenni a GPU-t.

A GeForce4 Ti chipek alapvető specifikációit az alábbi táblázat foglalja össze:

| GeForce4 Ti4600 | GeForce4 Ti4400 | GeForce4 Ti4200 | |

| Mag órajele | 300 MHz | 275 MHz | 225 MHz |

| Memória órajele | 650 MHz | 550 MHz | 500 MHz |

| Memória mérete | 128 MB | 128 MB | 128 MB |

| Sávszélesség | 10,4 GB/s | 8,8 GB/s | 8,0 GB/s |

| Fill rate | 1,2 Gpixel/s | 1,1 Gpixel/s | 900 Mpixel/s |

| Teljesítmény (háromszög/sec) | 136 millió | 125 millió | 100 millió |

| Várható ár (USD) | 399 | 299 | 199 |

A GeForce4 Ti jellemzői, újításai pedig a következők:

- nfiniteFX II engine

- Accuview Anti Aliasing

- Light Speed Memory Architecture II

- nView többkijelzős megjelenítés támogatása

A GeForce4 Ti mellett bejelentésre került a GeForce4 MX chipek családja is. Hogy ne legyen túlzottan egyszerű a tájékozódás a különféle grafikus chipek tömkelegében, ezekből is rögtön hárommal rukkolt elő a cég:

| GeForce4 MX460 | GeForce4 MX440 | GeForce4 MX420 | |

| Mag órajele | 300 MHz | 270 MHz | 250 MHz |

| Memória órajele | 550 MHz | 400 MHz | 166 MHz SDR |

| Memória mérete | 64 MB | 64 MB | 64 MB |

| Sávszélesség | 8,8 GB/s | 6,4 GB/s | 2,7 GB/s |

| Fill rate | 600 Mpixel/s | 540 Mpixel/s | 500 Mpixel/s |

| Teljesítmény (háromszög/sec) | 38 millió | 34 millió | 31 millió |

| Várható ár (USD) | 179 | 149 | 99 |

Ugyanakkor ki kell emelni, hogy a korábban NV17 kódnéven ismert GeForce4 MX megtévesztő neve ellenére nem egy lebutított GeForce4, sőt nem is egy butított GeForce3. Sokkal inkább tekinthető egy okosabb GeForce2 MX-nek, mint az előbbiek bármelyikének. A GeForce4 MX ugyanis nem tartalmaz programozható vertex és pixel shader egységeket, csupán egy, a GeForce-ban debütált hardveres T&L motort. S akárcsak a GeForce2 MX, a GeForce4 MX is mindössze 2 dual-textúrázásra képes pixel pipeline-nal rendelkezik. Ezért félő, hogy elnevezése nem a legszerencsésebb.

A negyedik GeForce MX változata minden kétséget kizáróan a ma elérhető játékok futtatására lett kitalálva. A GeForce4-től csupán a hangzatos Lightspeed Memory Architecture II, a többkijelzős megjelenítést támogató nView, valamint az Accuview anti-aliasing technológiát örökölte.

El kell mondani még, hogy az NVIDIA egyben bejelentette a GeForce4 MX GPU-k mobil változatait is, melyek GeForce4 440 Go és GeForce4 420 Go néven kerülnek forgalomba illetőleg hordozható számítógépekbe.

[oldal:Lightspeed Memory Architecture II]

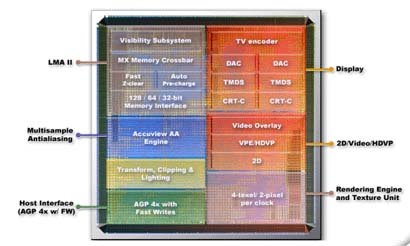

A modern grafikus chipekben illetve kártyákban talán a legnagyobb problémát a korlátozott memória-sávszélesség okozza. A tervezőmérnökök sokszor kénytelenek kompromisszumot kötni, ugyanis a memóriatechnológia nem fejlődik olyan gyorsan, mint ahogy a valós idejű grafikus ábrázolási eljárások illetve az ezekhez szükséges hardverek. Érdemes megjegyezni, hogy az utóbbi években a legnagyobb teljesítményű memóriachipeket a csúcskategóriás grafikus kártyákon találjuk.Bár az NVIDIA GeForce4 Ti 4600 memóriájának adatáteresztő képessége másodpercenként mintegy 10,4 Gbyte, ez még mindig kevés egy igazán komplex grafikus objektum gyors kezeléséhez. Ezért az NVIDIA mérnökei számos eljárást alkalmaztak a GeForce4 chipekben, amelyeknek a rendelkezésre álló sávszélesség növelése a célja. A Lightspeed Memory Architecture II névre keresztelt technológia-gyűjtemény a GeForce3-ból már ismert trükkök mellett számos újdonsággal szolgál.

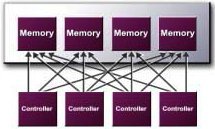

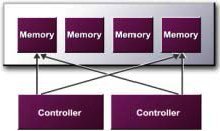

Crossbar Memory Controller

A GeForce3-ban debütált és az Xbox grafikus chipjében is megtalálható technológia lényege, hogy a chip grafikus vezérlője a valóságban több, egymástól teljesen független memóriavezérlőt takar. A modern grafikus kártyákon rendszerint 128 bites DDR SDRAM memóriát használnak, amely egy órajelciklus alatt legfeljebb 256 bit átvitelére képes. Azonban ha ennél kisebb méretű információ beolvasására vagy írására van szükség, az is teljesen lefoglalja a memóriavezérlőt, miközben a sávszélesség egy része pocsékba megy. A GeForce4 Ti memóriavezérlője négy, a GeForce4 MX-é pedig két független kontrollert tartalmaz, amelyek 64, 128 vagy 256 bites "csomagokban" képesek a memóriával kommunikálni -- attól függően, hogy az adott időpontban mekkor adat mozgatására van szükség. Ezzel akár 75 százalék sávszélesség is megtakarítható.

A GeForce4 Ti és GeForce4 MX crossbar memóriavezérlője

Quad Cache

A Lightspeed Memory Architecture II technológia egyik újítása a Quad Cache, amely a gyakorlatban négy gyors cache-memóriát jelent, amelyekben primitívek, vertexek, textúrák és pixelek adatait tárolja a GeForce4. Ezekből a chipen található memóriákból lényegében azonnal előhívhatók az itt található adatok, nem szükséges a memóriabuszt illetve az amúgy is szűkös sávszélességű AGP portot terhelni.

Auto Pre-charge

Az auto pre-charge a memóriatechnológiából adódó késleltetések csökkentésére szolgál. A DRAM chipek tárolórekeszeire, a "bankokra" oszlop és sor szerint lehet hivatkozni. Azonban csak és kizárólag az aktív bankban található információ érhető el azonnal, más bankok elérése előtt a nyitott bankot le kell zárni, a másikat pedig a sor és oszlop információk megadásával meg kell nyitni. Ez a folyamat a memóriában akár 10 órajelcikluson át is tarthat, ilyenkor a grafikus chip semmit nem csinál, csak az adatokra vár. Ezt hivatott redukálni az auto pre-charge, amely gyakorlatilag aktiválja azokat a memóriabankokat, amelyeknek a tartalmára a közeljövőben szükség lehet.

Z-puffer trükkök

A videochipek által legtöbbször írt és olvasott memóriaterület a Z-puffer, ezért ezek az elérések azok, amelyek a leginkább igénybe veszik a memóriát. A GeForce4 változtatás nélkül tartalmazza a GeForce3-ban megismert veszteség nélküli Z-puffer-tömörítés, Z Occlusion Culling, Occluion Query és Fast Z Clear eljárásokat, amelyek tovább növelik a rendelkezésre álló effektív sávszélességet.

Az NVIDIA GeForce4 tartalmaz egy 4:1 arányú Z-puffer-tömörítést, ami megvalósításában gyakorlatilag megegyezik az ATi Radeonban található módszerhez. Bár az NVIDIA eddig még nem adott ki ilyen jellegű dokumentációt, szinte biztosra vehető, hogy a GeForce4 is a chipen tárolja a Z-puffer éppen szükséges részét -- kérdés, hogy mekkorát. A Radeon esetében 64 byte-ot cache-el a chip. Szintén megtalálható a GeForce4-ban a Z-puffer gyors törlése (Fast Z Clear), melyet az ATi is alkalmazott.

A GeForce4 "Z Occlusion Culling" technológiája a pixeleket még renderelés előtt megvizsgálja, nincsenek-e takarásban. Ha igen, a pixel egyből "megy a szemétbe" és be sem kerül a Pixel Shaderbe, ezzel megspórolva jópár Z-puffer elérést. Az NVIDIA ezt még megfejelte egy "Occlusion Query" nevű eljárással, ami gyakorlatilag "bounding box" technológiát használva eldönti egy egész poligoncsoportról, hogy látható-e. A bounding box nem más, mint az adott objektumot teljesen magába foglaló legkisebb "doboz", azaz hasáb.

A Lightspeed Memory Architecture II legfigyelemreméltóbb tulajdonsága, hogy az alkalmazások számára teljesen transzparens, semmiféle programozói trükk vagy utasítás nem szükséges a technológia kiaknázásához.

[oldal:nfiniteFX II]

A tavaly tavasszal megjelent GeForce3-ban találkozhattunk először az nfiniteFX motorral, amely gyakorlatilag a chip pixel shader és vertex shader végrehajtóegységeit takarta. A GeForce4 Ti-ben található nfiniteFX II nevű motor legfontosabb újdonsága, hogy immár nem egy, hanem két vertex shader egységgel rendelkezik -- hasonlóan az Xbox grafikus chipjéhez. Ezáltal a GeForce4 Ti geometriai feldolgozóképessége jelentősen javult az elődjéhez képest.

A vertex shader a három dimenziós világot felépítő elemi részecskékkel, a vertexekkel, azaz a háromszögek csúcspontjaival dolgozik. A gyakorlatban egy olyan T&L motor, amely teljesen szabadon programozható és számos effektus létrehozható a segítségével. A vertex shader hardveres szemmel nem más, mint egy SIMD processzor, amelyet legfeljebb 128 utasításból álló programokkal lehet irányítani. A vertex shaderrel részletesen foglalkozott az NVIDIA GeForce3-ról szóló cikkünk, amely itt olvasható.

Mivel az egyes effektek létrehozásán felül az alapvető T&L feladatok is a vertex shadert terhelik, az NVIDIA szerint feltétlen szükséges volt egy második egység beiktatására, hogy a komplex számítást igénylő effektusok esetén ne kelljen kompromisszumot kötni a poligonszám tekintetében.

Az nfiniteFX II motor ezen felül a korábbinál fejlettebb pixel shadert is tartalmaz, amely már megfelel a pixel shader 1.2 és 1.3 specifikációknak. Bár az Ati Radeon 8500 pixel shaderei már az 1.4 verziónál tartanak, az NVIDIA nem tartotta fontosnak ezek implementációját. Az új pixel shader utasításokon kívül figyelemre méltó még Z-correct bump mapping eljárás támoigatása és javítottak a DXT1 technológiával tömörített textúrák kezelésén is. Ezen felül az NVIDIA mérnökei optimaliálták a textúrakezelést is, aminek köszönhetően a 3 vagy 4 textúrával rendelkező pixelek kiszámítása jelentősen gyorsult.

Az nfiniteFX II motor képességeinek demontrálására keltette életre a vállalat a félelmetes farkasembert, amely több mint 100 ezer poligonból áll. Wolfman mozgatásában illetve bundájának létrehozásában is a pixel/vertex shaderek segítenek.

[oldal:Accuview anti-aliasing]

A GeForce4-ben találkozhatunk először az Accuview névre keresztelt új anti-aliasing eljárással. Az anti-aliasing az aliasing jelenség, azaz a durva mintavételezésből adódó torzítás kiküszöbölésére szolgál. Ez a grafikus technológiában a kirajzolt kép szemcsézettségét, "pixelesedését" jelenti, amelyet többféleképp is meg lehet szüntetni.Az első otthoni piacra szánt, anti-aliasing eljárást tartalmazó grafikus chipek ún. Supersampling eljárással dolgoztak, ami azt jelenti, hogy a megjelenített képet nagyobb felbontással számolták ki, majd lekicsinyíteték azt. A Supersampling óriási hátránya azonban, hogy csak nagy teljesítményveszteség árán használható, hiszen a nagyobb felbontású kép kiszámításához nagyobb memóriasávszélesség illetve grafikus számítási teljesítmény szükségeltetett.

A GeForce3 és a GeForce4 multisampling alapú anti-aliasinget használ, amelyet teljesen hardveresen valósít meg. A chipek több mintát vesznek a képről, amelyeket eltárolnak, majd a kép megjelenítése előtt egymásra "retusálják" őket. Azonban a multisampling eljárás használatakor a mintákhoz ugyanazokat a textúraadatokat lehet felhasználni, ezzel jelentősen lecsökken a textúrák mozgatása által igényelt sávszélesség.

A GeForce4-et a kezdetektől fogva úgy tervezték, hogy gyors és jó minőségű anti-aliasinget nyújtson, ennek érdekében egyes belső adatbuszait a korábbiakhoz képes megnövelték. Ezzel elérték, hogy a chipek teljesítményveszteség nélkül képesek a minták kiszámítására, így gyakorlatilag csak a képek egymásra másolása lassítja a megjelenítést.

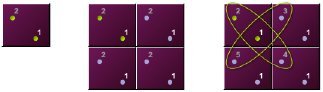

Mikor a Pixel Shader kirajzolta a jelenet utolsó pontját is, az anti-aliasing motor a két képet egymáshoz képest egy fél pixellel mindkét irányban eltolja. Így az első kép minden egyes pixelét a második kép 4 pixele veszi körül "egypergyökkettő" pixel távolságra. Ezután az öt pixel szűréséből előáll az anti-aliased pixel.

Fent a Quincunx, lent az Accuview antialiasing mintavételi pontjai

Az Accuview a mintavételek pontjában hoz változást, ugyanis míg a Quincunx esetében az egyik minta a pixel közepén, a másik a sarkában volt, Accuview eljárás használata esetén minkét minta a pixel belsejéből áll elő, ez az NVIDIA szerint szebb, kiegyensúlyozottabb képet ereményez. Az Accuview újdonsága még a 4xS anti-aliasing eljárás, amely egy pixel színének meghatározásához összesen 9 minta súlyozott átlagát használja, így a lehető legjobb minőségű képet adja. Az Accuview motor hardveresen támogatja az Anisotropic Filteringet, azaz az anizotropikus szűrést is.

Mint arról már írtunk, az Accuview nem csak az eddigieknél "szebb-jobb" képek előállítására alkalmas, hanem jelentősen gyorsabb is elődeinél. Az NVIDA által végzett tesztek szerint a GeForce2 illetve GeForce3 anti-aliasing teljesítménye "a kanyarban sincs" a GeForce4-éhez képest. Az NVIDIA tesztjeinél azonban sokkal többet mond az a tény, hogy a Comanche 4 helikopteres akciójáték csak és kizárólag GeForce4 chipes kártyákon támogat anti-aliasinget.

[oldal:nView, VPE és a vég]

Minden GeForce4 chipben (tehát a Ti és MX verziókban egyaránt) megtalálható továbbá az nView is, mely a korábbi NVIDIA termékekben már régóra elérhető TwinView többkijelzős megjelenítést támogató technológia továbbfejlesztett változata. Minden chip két független, 350 MHz-es RAMDAC-kal lett ellátva, és az integrált dekódereknek köszönhetően a ma elérhető megjelenítők minden változatára -- a katódsugárcsöves monitoroktól a lapos kijelzőkön át a HDTV-kig -- képes analóg vagy digitális jel formájában képet varázsolni. A több kijelző megfelelő konfigurálásnak megkönnyítésére az NVIDIA egyedi alkalmazást is mellékel a chipekhez.Továbbá a GeForce4 chipekben megjelent az ún. Video Processing Engine (VPE) is, mely lényegében nem takar mást, mint egy decens MPEG-2-dekódoló egységet, mellyel már jó ideje adós volt a cég. A VPE immár a motion compensation mellett támogatja az inverse quantization (IQ), inverse discrete cosine transform (IDCT) és color space conversion (CSC) funkciókat is. Ennek köszönhetően -- állítja az NVIDIA -- a videolejátszás közbeni processzorterhelés 90%-kal csökkenthető.

A vég

Azt hiszem, a fenti ismertetőből is látható, hogy az NVIDIA részben stratégiát váltott, pontosabban lassítani látszik a tempón. És ez nem feltétlenül baj. Nem feltétlenül baj a cég szempontjából, hiszen a jövőben -- éppen az Xbox árnyékában -- talán éppen az válik a legnagyobb kihívássá a gyártók számára, hogy érveket találjanak a vevők meggyőzésére: miért is érdemes megvásárolni az új és új termékeket? Mert, valljuk be, nehéz racionálisan indokolni, miért is lenne fontos számunkra egy óriási potenciállal rendelkező új chipbe fektetni pénzünket akkor, amikor például a játékpiacon alig, ha egyáltalán, kapható olyan játék, amelyik a két generációval korábbi chipek lehetőségeire épít.

És feltehetően jó ez nekünk is, ahogy a játékfejlesztőknek is, hiszen a lassabb ütemű fejlődés talán előbb-utóbb lehetővé teszi, hogy ne csupán csilivili technológiai demók futtatásakor csodálhassuk meg egy chip képességeit, hanem valós alkalmazások, játékok során is.

A GeForce4-ről tesztek olvashatók angol nyelven az alábbi oldalakon:

Egy magyar nyelvű technológiai bemutató pedig a prohardver! oldalán is megjelent.

A GeForce4 bemutató során látható technológiai demókról készült videofelvételek az NVIDIA honlapján tekinthetők meg.