Grafikus kártyaként is kiadja a GK110-et az NVIDIA

Váratlan lépésre szánta el magát az NVIDIA, GeForce márkanéven is kiadta a mérnöki-tudományos rendszerekbe szánt csúcsteljesítményű chipjét. Elrajtolt a GeForce GTX Titan.

Tegnap az NVIDIA bejelentette eddigi legerősebb grafikus chipjét, a GTX Titant. A lapka valójában nem új fejlesztés, a tavaly bemutatott Teslát csomagolta újra a vállalat, hogy nagyobb tömegek számára is elérhető legyen. Persze a 999 dolláros ajánlott bolti ár ezt a tömeget eléggé le fogja szűkíteni.

Csúcsteljesítmény az asztalon

Majdnem egy éve már, hogy az NVIDIA először beszélt legújabb generációs csúcskategóriás chipjéről, a K20-ról, amely végül 2012 őszén napvilágot is látott - ilyen processzorok dolgoznak a Titan fantázianevű szuperszámítógépben is, amely 17,6 petaflopsos teljesítményével jelenleg a legerősebb a világon a Top500 lista szerint. A lapkát a vállalat kezdetektől fogva a tudományos számítások elvégzésére tervezte, ennek megfelelően hatalmas: 7,1 milliárd tranzisztorból áll és 551 mm2 méretű. 28 nanométeres csíkszélességen gyártja a TSMC, a chip csúcsfogyasztása 250 watt.

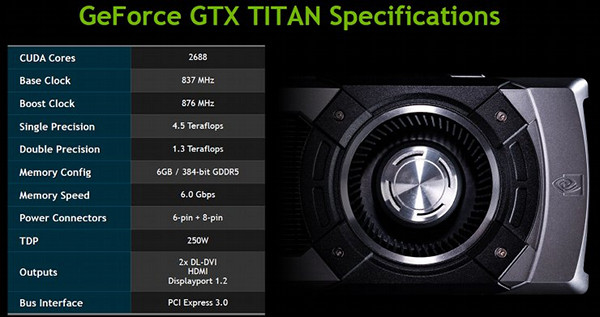

A Titannek 15-ből 14 SMX egysége aktív, ami összesen 2688 stream processzort (NVIDIA terminológia szerint CUDA magot) jelent, 224 textúrázója és 48 ROP egysége van, magórajele 837 MHz, de turbóval ez 876 MHz-re is emelkedhet, amennyiben a termikus keret ezt lehetővé teszi. A chip konkrét teljesítménye egyelőre nem ismert, mivel az NVIDIA PR-részlege azokat titokban tartja és a szaksajtó sem írhat róla még, de feltehetően a legerősebb egychipes megoldással állunk szemben - a nyers teljesítmény 4,5 teraflops FP32 műveletek esetén, a cég által kiadott információ szerint FP64 számításoknál a sebesség harmadára csökken.

Égbe révedő informatikusok: az Időkép-sztori Mi fán terem az előrejelzés, hogy milyen infrastruktúra dolgozik az Időkép alatt, mi várható a deep learning modellek térnyerésével?

A grafikus lapka mellé a kártyákra 6 gigabájt GDDR5 memória kerül, amelynek effektív órajele 6 GHz. A memóriabusz 384 bites, ez másodpercenként 288 gigabájtos memória-sávszélességet jelent. Ezzel a GTX 680-at messze maga mögött hagyja a GTX Titan, de a kétchipes GTX 690 (2x256 bites busz, 6 GHz GDDR5) 384 gigabájtos elméleti maximumát nem éri el. Fontos megjegyezni, hogy a Teslával ellentétben a memória nem kapott ECC védelmet, az NVIDIA ezzel is megpróbálja differenciálni a két termékvonalat.

Nem csak játékőrülteknek

Noha GeForce GTX néven kerül piacra és akár grafikus feladatok végrehajtására is alkalmas, játszani is lehet rajta, a Titant valószínűleg mégsem gamerek vásárolják majd elsősorban, hanem olyan felhasználók, akik a lehető legnagyobb teljesítményt szeretnék kihozni egy asztali gépből - kutatók, fejlesztők, mérnökök. Az ő bérköltségük mellett a 999 dolláros ajánlott bolti ár sem tűnik földtől elrugaszkodottnak, ha figyelembe vesszük, hogy egy GeForce GTX 680-nál mennyivel nagyobb teljesítményhez juthatnak és ennek köszönhetően például hamarabb végezhetnek a feladataikkal vagy pontosan számítási modelleket használhatnak, ami sokszorosan megtérülhet.

Az NVIDIA azért gondolt a gamerekre is, és néhány PC-gyártóval összeállva kis méretű, könnyen hordozható gamer konfigurációkat álmodtak meg - ezek ára azonban csak tényleg a legelvetemültebbek számára lesz elfogadható.