Larrabee: az Intel frontális támadása a Radeon és GeForce ellen

A számítógépes grafikai ipar legmagasabb presztízsű konferenciája, a SIGGRAPH közeledtével az Intel újabb információkat csepegtetett nagyteljesítményű vizualizációs architektúrájáról. A Larrabee kódnéven ismert fejlesztés hátterében egy védekező lépés áll, melynek célja megakadályozni, hogy Intel processzorokról más chipekre migráljon teljesítményéhes kódok egyre nagyobb tömege, ennek érdekében pedig közvetlen tűz alá veszi az AMD és NVIDIA grafikus chipjeit.

Ütközési pályán

Az Intel az elmúlt években egyre szélesebb nyilvánosság előtt kezdett el beszélni arról, hogy az általános célú mikroprocesszorok és a grafikus processzorok egymás felé közelítenek, sőt ütközési pályán mozognak, és belátható időn belül egyre bővülő alkalmazási területen számítanak majd egymás konkurenseinek. Miközben a processzorok az energiahatékonyság követelménye miatt egyre inkább a párhuzamosság felé mozdulnak el a magok számának és a vektoros teljesítmény fokozásával, addig a grafikai oldalról érkező, masszívan párhuzamos felépítésű grafikus architektúrák a rugalmasabb programozhatóság felé haladnak.

Az AMD által bekebelezett ATI és az NVIDIA ezirányú erőfeszítéseinek első gyümölcseit már láthatjuk a közelmúltban megjelent termékeikkel kapcsolatban. Az NVIDIA CUDA compilerrel és fejlesztői eszközökkel magas adatszintű párhuzamosságot mutató kódokat már lehet kiváló eredménnyel portolni a GeForce G80-as generációtól kezdve felfelé. A Folding@Home fehérjekutatást egy GTX 280 chip 45 százalékkal gyorsabban futtatja, mint egy 3 gigahertzes Core 2 Quad, a projekttulajdonos Stanford Egyetem állítása alapján.

Ne gondoljuk azonban, hogy a tudományos non-profit projekt egyedi: a CUDA-t támogató kereskedelmi szoftverek választéka is már meglepően széles, így például h.264 enkódolótól az áramlástani szimulátoron át szeizmológiai és pénzügyi adatelemző alkalmazásokat találunk, melyek 10-100-szoros gyorsulást ígérnek a legújabb GeForce kártyák használatával a mikroprocesszorokhoz képest. Bár szakmai vélemények szerint az NVIDIA a grafikus chipek programozhatósága terén a CUDA révén lépéselőnyt élvez az AMD Stream SDK-val szemben szemben, a rivális kétségtelenül hasonló irányba lépked, és hatásos erődemonstrációt tartott néhány hónappal ezelőtt valósidőben futó ray-tracing demókkal. Szintén a grafikus chipek alkalmazhatósági köre bővülését jelzi, hogy a játékok fizikájának számításait is igyekeznek átvenni.

A gyenge, alacsony fogyasztásra és olcsó gyárthatóságra optimalizált integrált grafikus chipekkel bíró Intel számára ez pedig nem jelent mást, minthogy az évente több milliárd dollár nyereséget termelő mikroprocesszorai egyre több és több feladatot vesztenek el, elsősorban szuperszámítógépes és professzionális munkaállomás területeken, ezzel pedig a vállalat piacot és pénzt veszít, hosszú távon pedig paripát és fegyvert is. Ezt a veszélyt felismerve a világ legnagyobb chipgyártója nyilvánvalóan meg akarja akadályozni, hogy Intel szilíciumról máshova vándoroljanak a számítási kapacitások. Ez a motiváció szülte meg a Larrabee projektet, melynek célja egy olyan architektúra megalkotása, mely a mikroprocesszorok programozhatóságával, és grafikus processzorok masszív párhuzamosságával egyszerre rendelkezik -- másképpen fogalmazva az Intel előrenyomul az CPU-GPU ütközési pontra.

Kevés új részlet

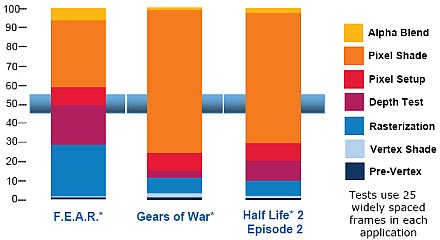

Pénteken közzétett összefoglalójában, mely a SIGGRAPH prezentáció előzetese, az Intel a Larrabee grafikus chipekkel szembeni előnyeit ecsetelte, és kevés technikai újdonság látott valójában napvilágot. Különböző játékok kódjainak elemzésével az Intel arra a következtetésre jutott, hogy nincsenek tipikus futásidejű jellemzők, a játékok között, és egy játék futása közben is nagymértékben változékony képet mutat az egyes feladatrészek erőforrásigényének aránya.

Így például a Gears of Warban a pixel árnyalás dominál, közel kétszer annyi időt köt le, mint a F.E.A.R esetében, ahol viszont a mélységvizsgálat és raszterizáció bír nagyobb súllyal -- ezek az arányok egy játékon belül is nagy dinamikával változnak, ami az erőforrások kihasználtsága mellett a sávszélességigényre is kihatással van. Közismert, hogy a mai grafikus megoldások különösen érzékenyek a sávszélességre, amire az Intel a "binning rendering" nevezetű megoldást kínálja. Szemben az úgynevezett azonnali módú rendereléskor, mikor minden egyes pixelhez távoli memóriahívások tartoznak. A binek, vagyis ládikók a kép egy-egy szeletével kapcsolatos pixeladatokat tartalmazza, és az L2 cache tárolja azokat, takarékoskodva a körbusz és a beágyazott és központi memória sávszélességeivel.

Az Intel szerint a Larrabee teljesen rugalmasan allokálható általános célú erőforrásai révén hatékonyabban alkalmazható a játékok képalkotási folyamatában, ahol az egyes munkafázisokat nem hardveresen dedikált logika végzi, hanem a tetszőlegesen használható vektoregységek, míg a programozhatóságot és vezérlést az x86-os mag biztosítja.

Az Intel szerint a Larrabee teljesen rugalmasan allokálható általános célú erőforrásai révén hatékonyabban alkalmazható a játékok képalkotási folyamatában, ahol az egyes munkafázisokat nem hardveresen dedikált logika végzi, hanem a tetszőlegesen használható vektoregységek, míg a programozhatóságot és vezérlést az x86-os mag biztosítja.

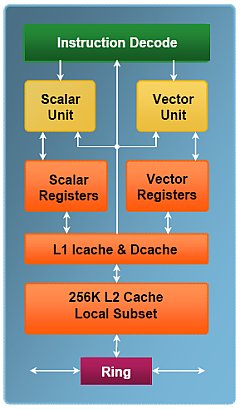

A chip körbuszon kapcsol össze sok, valószínűleg több tucat soros végrehajtású skalár, rövid futószalaggal bíró teljesértékű x86-os processzormagokat, melyek teljesen koherens L1-L2 (utóbb 256k méretű) cache-hierarchiával bírnak, de a munka nagy részét dedikált regiszterszettel bíró 256 bites vektoregységek végzik majd, melyek órajelenként 16 darab egyszeres precizitású lebegőpontos művelet végrehajtására képesek -- nincsen dedikált grafikus logika a magokban, a chipen ugyanakkor találni dedikált textúrázó logikát, amit a hatékonyság indokol. Az erőforrások kihasználtságának fokozása érdekében a magok 4 utasításszálat kezelhetnek egyszerre, melyek közül egy a másik három számára készíti elő a feladatokat.

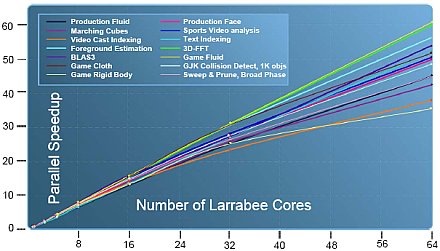

Az Intel részben grafikus chipnek szánja a Larrabee-t, ennek megfelelően a driver segítségével képes lesz renderelni DirectX és OpenGL kódutakkal, de teljesen szoftveresen is, akár ray-tracinget is alkalmazva. Egyúttal azonban sokkal szélesebb körű felhasználás a cél, így a C/C++ kódolási környezet magától értetődő, mely programok natívan futhatnak a chipen majd. A megcélzott kódok közé a grafikus chipek esetében fentebb említettek tartoznak, így számításintenzív műszaki-tudományos szimulációk, vizualizáció, gyors adatelemzések. Az Intel szimulációi szerint a Larrabee jól skálázódik a magok számával, és 55-95 százalékos hatékonyságot mutat fel még 64 mag megléte esetén is.

A Larrabee elektronikai implementációjának részleteiről, a magok számáról és teljesítménypotenciáljáról továbbra sem nyilatkozott az Intel, ugyanakkor távoli, 2009 végére, 2010-re tehető megjelenése miatt ez nem is meglepő. Az mindenesetre bizonyosnak látszik, hogy a chippel az Intel komoly versenyzővé válik a grafikus és a masszívan párhuzamos architektúrájú processzorok terén egyaránt, és jó eredményesen veheti fel a harcot az AMD és az NVIDIA, valamint újabban az IBM Cell-fejlesztéseivel egyaránt.