Olcsóbb HBM memóriákat akar a Samsung

Enyhítené a HBM memóriák legnagyobb problémáját a Samsung, ehhez a cég egy olcsóbb implementáción dolgozik, ami megkönnyíthetné a számos előnnyel kecsegtető megoldás terjedését.

Olcsóbban implementálható HBM-en, azaz nagy sávszélességű rétegzett memórián dolgozik a Samsung. A dél-koreai cég úgy csökkentené a komplexitást, hogy közben a lehető legkisebb csorbát szenvedné az elérhető maximális sávszélesség. Az olcsóbb megoldások meggyorsíthatnák a HBM memóriák terjedését, ez pedig több felhasználási terület fejlődését is elősegítené.

Nehezen vitatható, hogy jelenleg a HBM (High Bandwidth Memory) jelenti a jövőt az integrált vagy beágyazott memóriák kínálatában. A több lapkát rétegző fejlesztés az egyes DDR és GDDR szabványú megoldásokhoz képest úgy növeli jelentősen a sávszélességet és a kapacitást, hogy közben a fogyasztás, illetve a memóriák helyigénye is számottevően csökken, azaz gyakorlatilag az összes fontos paraméterben előrelép. Az alacsony fogyasztást az 1024 bites I/O kiépítésnek köszönheti a HBM, a rendkívül széles párhuzamos adatúttal ugyanis alacsonyan tartható az órajel, a jelenlegi leggyorsabb, 256 GB/s-ra képes chipek frekvenciája csupán 1 GHz.

Mindennek ugyanakkor komoly ára van, mégpedig a szó legszorosabb értelmében. A széles adatbusz chipenként nagyjából 4000 vezetéket igényel, melyek elvezetése komoly kihívást jelent, pláne akkor, ha több, mondjuk négy lapka kerül az ASIC (pl. GPU) mellé. Ebben az esetben egy úgynevezett interpózer szükséges, ami jelenleg egy, az összes arra kerülő lapkánál nagyobb területű szilícium. Ezen keresztül fut át (például) a GPU és a szorosan mellette található HBM chipek összes vezetéke, illetve ebben kapcsolódik össze a processzor a memóriákkal, a megoldást az iparág 2.5D rétegzésnek (stacking) nevezi.

Mindez költséges és komplikált, ennek pedig nem csak a központi lapka területénél jellemzően 50-60 százalékkal nagyobb interpózer az oka. A négy HBM chip esetében szükséges, összesen közel 20 000 vezetéket ugyanis mindössze 800-900 mm2-es területen kell megfelelően elrendezni. Utóbbi a félvezetőgyártásban jártas cégeknek is nagy kihívást jelent, az összeállítás során számos probléma léphet fel, ami az alacsonyabb elérhető memóriaórajelektől kezdve akár működésképtelen lapkákban is testesülhet. Az első, HBM lapkát tömegtermelésben alkalmazó AMD Fiji GPU-nak ezért kellett több cég kezén is átmennie, a grafikus chip összeállításához a GPU lapkáját gyártó TSMC mellett az interpózert készítő UMC, illetve a HBM chipeket szállító SK Hynix közreműködése is kellett, a gyártás végső fázisát pedig egy negyedik cég, az ASE végezte.

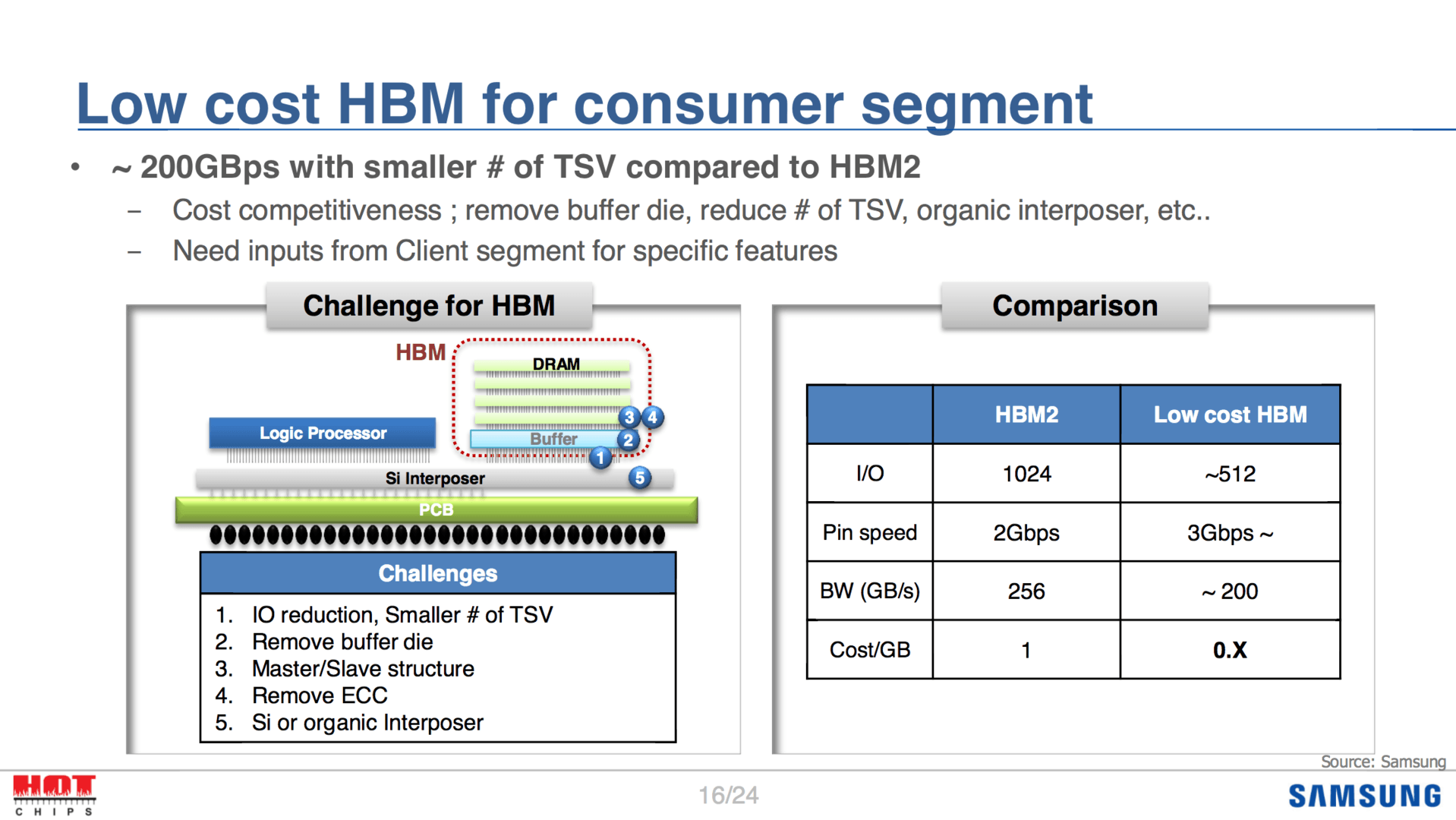

Mindezek tükrében nem csoda, hogy bőven lenne igény egyszerűbb alternatívára, még ha az bizonyos kompromisszumokat is kíván. A Samsung a cél érdekében visszalépne egyet, amivel elsőként a 1024 bites I/O kiépítést felezné meg 512 bitesre úgy, hogy kevesebb lapkát rétegezne egymásra. Ezzel a chiphez szükséges vezetékek száma közel felére csökkenne, ugyanakkor ezzel párhuzamosan az elérhető sávszélesség is feleződne. A Samsung ezért 50 százalékkal megnövelné a chipek órajelét, ami félig kompenzálná a szűkebb I/O-ból fakadó veszteséget, bár hátulütője ennek is lenne, hisz ily módon nőne a fogyasztás. A Samsung arról egyelőre nem beszélt, hogy a lapkák feszültségéhez hozzányúlna-e, de alacsonyabb értékkel valamelyest kompenzálható lenne a magasabb órajelből fakadó megnövekedett disszipáció.

Nagy pénz, nagy szívás: útravaló csúcstámadó IT-soknak Az informatikai vezetősködés sokak álma, de az árnyoldalaival kevesen vannak tisztában.

Emellett a Samsung eltávolítaná a puffer lapkát, illetve az ECC-t, valamint az ahhoz szükséges tárhelyet is kihagyná, és olcsóbb, organikus interpózert alkalmazna, melyekkel a dél-koreai cég szerint tovább csökkenthetőek a költségek. A cég kalkulációja szerint így az eddigieknél lényegesen olcsóbban lehetne implementálni egy közel 200 GB/s-os sávszélességre képes HBM chipet, ami új felhasználási területeket nyitna meg a memória előtt.

Már a HBM3 is készül

Eközben már a HBM2-t követő megoldáson is dolgozik a szabvány mellett álló két vállalat, az SK Hynix és a Samsung. Bár a véglegesítés még odébb van, az eddigi információk szerint a két cég tovább emelné a sávszélességet, így egyetlen chippel már 512 GB/s-os sávszélességet lehetne elérni, miközben a kapacitás is nőne, jelen állás szerint legalább duplájára. Ezzel ugyancsak csökkenteni lehetne a költségeket, hisz így kevesebb chipből lehetne összeállítani egységnyi sávszélességet és kapacitást. A harmadik generációs HBM érkezését 2019-2020 környékére datálja az említett két gyártó.